百度蜘蛛ip220和116段质量高,抓取很多

通过对服务器日志的分析,发现百度蜘蛛ip段116.179.32.*和220.181.108.*两段百度蜘蛛抓取量很多,也是主要的抓取ip段。我们从日志中可以清楚的看到大量的这两个ip段蜘蛛在访问网站的内页。

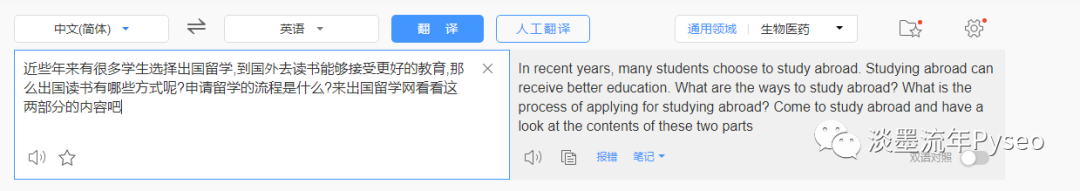

我们在服务器中,下载网站的日志文件,再把日志文件导入到特定的日志分析工具中,可以看到百度蜘蛛抓取网站页面的情况。可以通过下图,蜘蛛ip地址主要集中在220.181.108.*和116.179.32.*。这两个蜘蛛ip在大量抓取网站的内页。

通过ip138网站去分析ip的来源,其中116段ip是来自山西百度蜘蛛。220段ip是来自北京百度蜘蛛。都是百度蜘蛛标识。所以抓取上都是正确的。

这两段ip的百度蜘蛛抓取量很多。基本上百度方面的蜘蛛就已经抓取了2000多次了。不过发现了一个方法,可以提高220段蜘蛛的抓取量。就是百度站长平台抓取诊断里可以手动提交链接,然后就会发现220ip蜘蛛就会实时的抓取网站页面。

百度抓取诊断提交链接,每周只能提交70次,数量上有了很大的限制。不知道是出于什么原因限制次数。但是如果我们有大量的站点,或者批量绑定泛二级域名。这样提交的量就会有很多了。那么这里就要用到批量二级域名绑定软件了。可以自动化的进行二级域名批量绑定、删除、推送。

绑定完站点,其次进行10次主动推送,进行70次抓取诊断提交。然后进行删除处理,再去自动重复操作这一流程,这样就可以达到大量提交站点的目的了。